Willkommen bei BlueGlass - Ihre neue SEO Agentur

Wir sind ein engagiertes Team von neun erfahrenen SEO-Experten mit einer beeindruckenden Gesamterfahrung von über 45 Jahren auf dem Gebiet der Suchmaschinenoptimierung.

Seit unserer Gründung vor 15 Jahren, haben wir uns als führende SEO-Agentur der Schweiz etabliert, die die digitale Präsenz unserer Kunden durch smarte SEO-Strategien nachweislich verbessert und kontinuierlich positive Resultate liefern.

Lassen Sie uns gemeinsam erkunden, wie sich unsere SEO-Expertise nahtlos in Ihre Arbeitsprozesse einfügen kann und die Ergebnisse Ihrer Marketingaktivitäten auf positive und wirkungsvolle Weise verbessern kann.

- SEO-Analysen bilden die datenbasierte Grundlage für alle Entscheidungen.

- SEO-Strategien sind gezielt auf Bedürfnisse Ihrer Zielgruppe zugeschnitten.

- SEO-Beratung führen wir auf Augenhöhe als Ihr Sparring-Partner.

- SEO-Know-How wird von uns vermittelt und befähigt Sie Entscheidungen zu treffen.

- SEO-Reporting dient Ihrer Erfolgsmessung und macht den SEO-Impact sichtbar.

- SEO mit BlueGlass ermöglicht Ihnen langfristig und nachhaltig auf Google gefunden zu werden.

Unsere SEO Services

SEO-Audit

Relaunch Beratung

Technical SEO

International SEO

Online Reputation Management

Darum ist BlueGlass Ihre SEO-Agentur

Wir bieten SEO seit 15 Jahren als Kernkompetenz an und wissen durch unsere Erfahrung als SEO-Agentur, wie wir Ihr Unternehmen zum Erfolg bringen.

Wir verfügen über ausgewiesene Kompetenz im Bereich Technical SEO, OnPage- und OffPage-Optimierung, Local SEO, International SEO sowie Content Marketing

Wir sind erfahren im Umgang mit komplexen Website-Anforderungen, insbesondere im E-Commerce und CMS wie WordPress, Adobe Experience Manager oder Magnolia.

Wir erstellen Inhalte, die zu positiven User-Signalen führen, weil sie die Bedürfnisse und Intention der Zielgruppe treffen.

Die Umsetzung unserer datenbasierten SEO-Strategien gelingt uns durch gezielten Einsatz hilfreicher SEO-Tools wie Searchmetrics, Semrush oder Screaming Frog.

Wir sind ein ausgezeichnetes SEO-Team mit nachvollziehbaren Case Studies, welches unsere Expertise im SEO und Content Marketing beweist.

Lernen Sie unser SEO Team kennen

Kontaktformular

Häufig gestellte Fragen (FAQ) zu SEO-Beratung

Wie viel sollte in eine SEO-Beratung investiert werden?

Die Investition für eine SEO-Beratung variiert je nach Bedürfnissen der Kunden. Wenn Sie als Unternehmen angewiesen sind auf Ihre Webseite, um Leads oder Verkäufe zu erzielen, unterstützen wir Sie mit einer holistischen Beratung. Haben Sie ein spezifisches Bedürfnis, wo wir mit einer Analyse oder einem Bericht weiterhelfen können, wird es auf ein kleineres SEO-Projekt hinauslaufen.

Wie lange dauert es, bis die getroffenen SEO-Massnahmen erste Resultate zeigen?

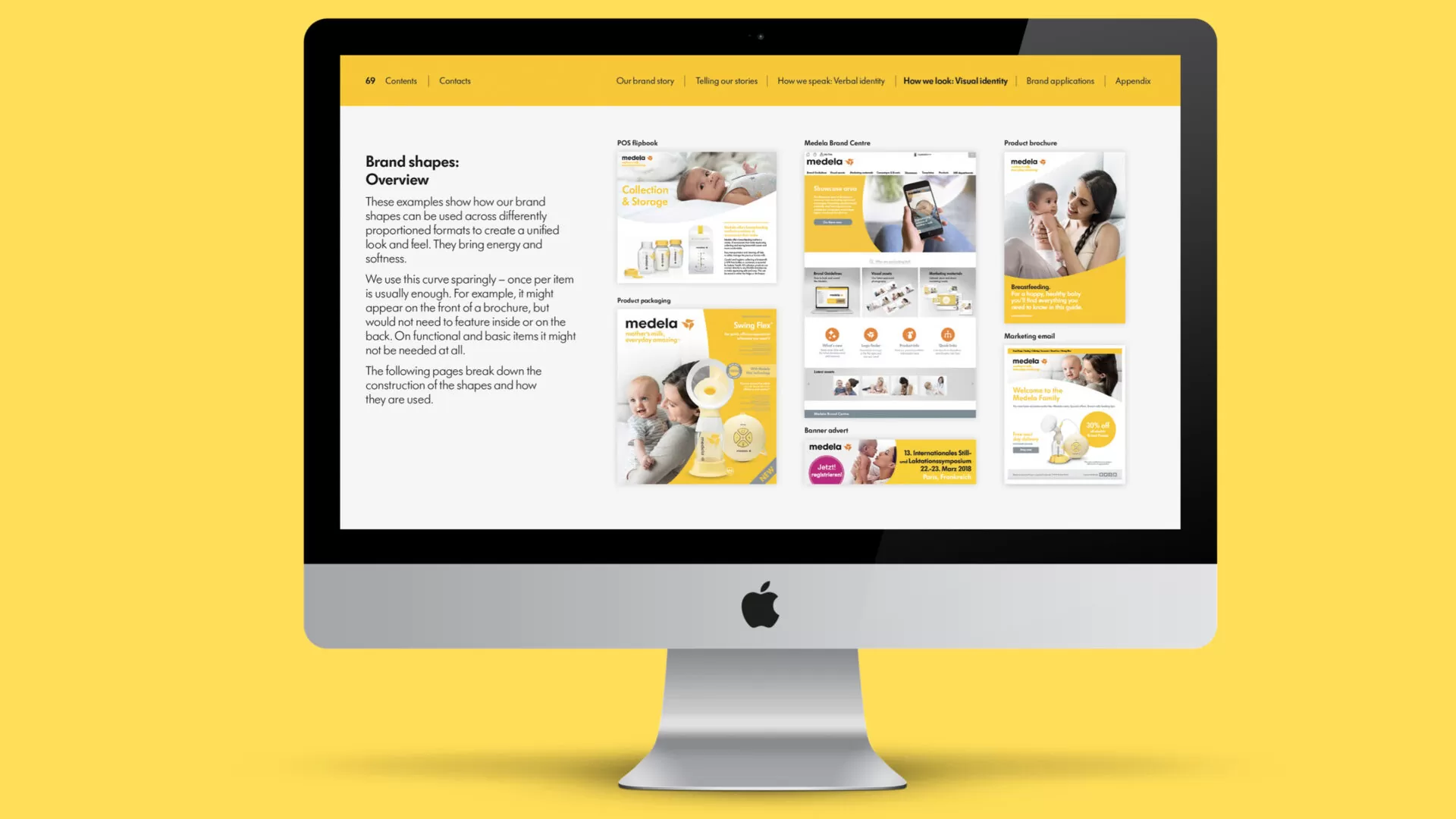

Je nach Massnahme kann es nur ein paar Tage dauern, bis die ersten Auswirkungen messbar werden. Grössere Massnahmen können mehrere Wochen benötigen, bis sie die volle Wirkung entfaltet haben, was z.B. auch in unserer Case Study zu Medela nachzulesen ist.

Wie messen wir Erfolg im SEO?

Wir sind erfolgreich, wenn wir die gemeinsam definierten Ziele mit unseren Kunden erreicht haben.

Im Bereich Awareness sprechen wir z.B. über KPIs wie Anzahl Klicks oder Impressionen über die organische Suche, aber auch Keyword Rankings gemessen mit SEO-Monitoring Tools wie Searchmetrics oder Semrush.

Im transaktionalen Bereich liegt unser Fokus auf Soft- und Hard-Conversions wie z.B. Scroll-Tiefe oder Anzahl übermittelter Kontaktanfragen.

Es gibt noch diverse, viel spezifischere Spezialziele, welche wir immer im Einklang der Marketing bzw. Businessziele unserer Kunden definieren.

Nutzen wir KI für die SEO-Optimierung?

Ja, wir setzen KI in unserer täglichen Arbeit ein. Wir nutzen die AI-Power, um schneller zu recherchieren, schneller Inhalte zu verstehen und mehr Sichtweisen auf Themen zu erlangen. Unser Ziel ist es, den Mehrwert der AI an unsere Kunden weiterzugeben.

Aktuelles aus der SEO Welt